Unser Gesichtsausdruck verrät viel mehr, als wir glauben. Nur die wenigsten können wirklich auf Dauer ein Pokerface zeigen, selbst wenn sie es wollten. Die Gesichtszüge entgleiten uns wieder, sobald wir nicht mehr konzentriert sind. Wir teilen also unserer Umwelt bewusst oder unbewusst ständig mit, wie wir die Situation bewerten und wie wir uns gerade fühlen.

Natürlich weckt dieses Phänomen Begehrlichkeiten in der Marktforschung. Die methodischen Probleme von schriftlichen oder mündlichen Befragungen sind bekannt – Menschen geben dabei nicht alles preis, vor allem keine unbewussten Einstellungen und Emotionen. Kann man möglicherweise mehr erfahren, wenn man die Botschaften entschlüsselt, die der Gesichtsausdruck sendet?

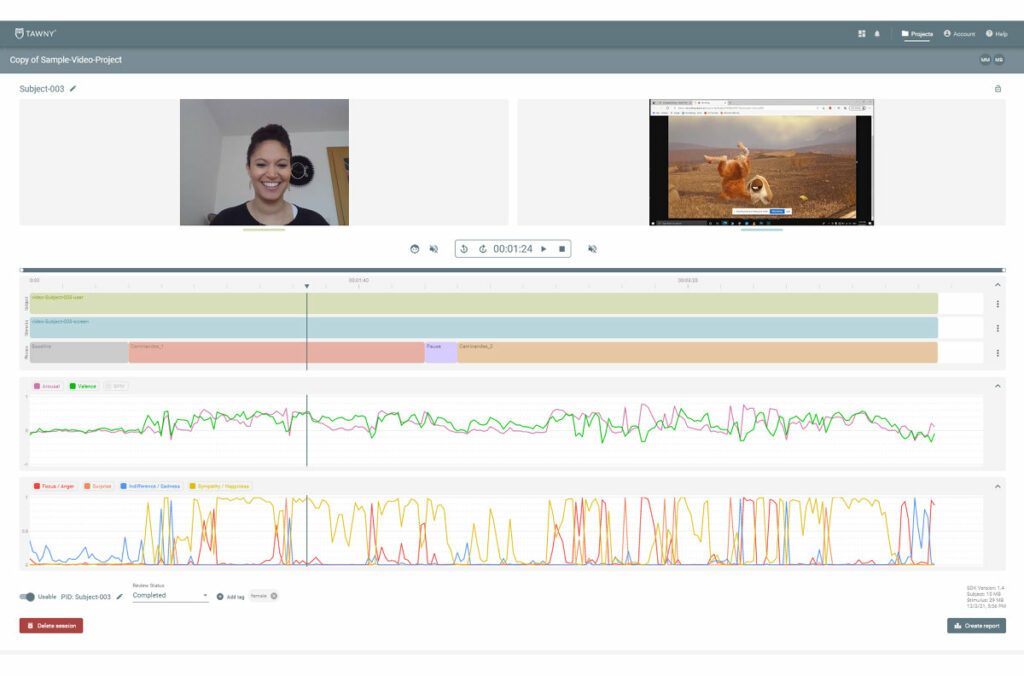

Auf jeden Fall, sagt Michael Bartl, der sich als Gründer des Münchner Start-ups Tawny schon seit Jahren intensiv mit dem sogenannten „Facial Coding“ beschäftigt. Tawny hat 2020 eine Emotionsanalyse-Plattform auf den Markt gebracht. Sie macht es möglich, über Videoaufnahmen die Emotionen von Menschen zu entschlüsseln. „Damit macht die Forschung einen großen Sprung“, sagt Bartl. „Das System bringt sehr präzise Ergebnisse und macht gleichzeitig über die Remote-Technologie aufwendige Labortests überflüssig.“

Zur Anwendung kommt das System bislang vor allem für Tests von TV- und Videospots. Das Prozedere: Proband*innen werden gefilmt, während sie einen Film betrachten. Die Technologie ermittelt über ihre Mimik, was sie dabei fühlen. Die Klassifizierung der Emotionen folgt dem Facial Action Coding System (FACS), das die amerikanischen Psychologen Paul Ekman und Wallace Friesen erstmals 1978 vorgestellt haben.

44 verschiedene Bewegungen verraten unsere Gefühle

Danach lassen sich im Gesichtsausdruck 44 mimische Bewegungseinheiten – vom „Zusammenziehen der Augenbrauen“ über das „Rümpfen der Nase“ bis zum „Öffnen der Lippen“ – unterscheiden. Diese lassen sich sieben Basisemotionen – Wut, Trauer, Freude, Ekel, Verachtung, Angst und Überraschung – zuordnen. Dabei kommt es auch darauf an, wie stark die einzelnen Bewegungen ausgeprägt sind. Das Tawny-System zeigt jeweils an, mit welcher prozentualen Wahrscheinlichkeit eine Emotion zu einem jeweiligen Zeitpunkt auftritt. Die Messung erfolgt entlang zweier Komponenten: Die Valenz beschreibt, ob die Emotion positiv oder negativ ist, das Arousal gibt an, ob die Person mehr oder weniger aufgeregt oder erregt ist.

Zusätzlich wird eine Aufmerksamkeitsanalyse durch Webcam-Eyetracking durchgeführt. Zudem kommt eine kamerabasierte Herzratenerkennung zum Einsatz, die auf digitaler Analyse der Strömung in den Venen und der Farbveränderung der Haut basiert. „Wir ergänzen die technische Messung dann gern noch mit einem Fragebogen mit expliziten Fragen nach der Wirkung von Spots“, sagt Bartl.

Anhand dieser Daten lassen sich viele Erkenntnisse gewinnen: Welche Reaktionen und Gefühle weckt ein Spot? Welche Variante funktioniert am besten? Stimmt die Dramaturgie? Dabei arbeitet Tawny mit dem Hook-Peak-End-Modell (HPE), das auf die Peak-End-Rule-Theorie des Psychologen und Nobelpreisträgers Daniel Kahneman zurückgeht. Er geht davon aus, dass Menschen Ereignisse nur nach einzelnen emotionalen Höhepunkten und dem Ende beurteilen, nicht nach ihrem gesamten Ablauf. Darauf basierend besagt das HPE-Modell, dass ein Spot einen emotionalen Trigger am Anfang braucht, einen oder mehrere Höhepunkte und einen gelungenen Abschluss. Ist diese Dramaturgie gegeben, behalten die Rezipient*innen den Spot in positiver Erinnerung.

Benchmark-Datenbank liefert umfangreiche Vergleichsmöglichkeiten

„Natürlich weiß man nur, wie gut ein Spot wirkt, wenn man Vergleichsmöglichkeiten hat“, betont Bartl. Tawny hat daher eine Datenbank mit Spot-Analysen aus Branchen wie Handel, FMCG und Technologie angelegt, die mittlerweile mehr als 20.000 Sessions mit Proband*innen enthält. Mithilfe der Datenbank lassen sich die entsprechenden Benchmarks ermitteln.

Unternehmen können die Emotionsanalyse-Plattform als SaaS-Anwendung auf Jahresbasis mieten. Monatlich fallen dann Kosten ab 199 Euro an. Wer die Untersuchungen nicht selbst durchführen will, kann auch Tawny komplett damit beauftragen. Im Full Service kosten Projekte zur Wirkung von TV-Spots, Online-Video, Websites oder Out-of-Home-Billboards 5000 Euro aufwärts.

Zu den Kunden von Tawny gehören bislang unter anderem Red Bull Media, SAP und Ströer sowie die Marktforschungsinstitute GfK, Innofact, Rheingold Institut und Psyma. Eine besondere Kooperation wurde 2021 mit mScience, der Marktforschungs-Unit der Mediaagenturgruppe GroupM, eingestielt. mScience nutzt die Technologie von Tawny für ein Tool, über das die Wirkung von Out-of-Home-Werbemitteln gemessen werden kann. Es heißt „EROC – Emotional Reactions on Creatives“ und kombiniert die KI-basierte Emotionsmessung mit expliziten Online-Fragebögen. Tawny sei „der erste und einzige Player im Markt, der Emotionen mittels sogenanntem Facial Coding auch für statische Werbemittel ermitteln kann“, ließ die GroupM dazu verlauten.

„Tawny Inside“: Auch im Auto lässt sich Facial Coding einsetzen

Aber liegt in der fehlenden Laborsituation nicht ein

methodisches Manko? Immerhin ist es dort möglich, fast alle Körperreaktionen akkurat zu messen, bis hin zum Hirn-Scan. „Dabei verzerrt man aber die Ergebnisse, weil die Situation sehr irritierend auf die Testpersonen wirkt“, betont Bartl. „Das Remote-Setting ist viel näher an der realistischen Rezeptionssituation.“

Neben der Werbewirkungsforschung sind viele weitere Anwendungen des Facial-Coding-Systems möglich. Man kann beispielsweise analysieren, wie Personen eine Videokonferenz erleben. Auch Sicherheits-Features sind möglich: Kameras im Auto können erkennen, wenn der Mensch am Steuer weniger aufmerksam wird. Bartl hat die Vision – nach dem Vorbild von Intel –, eine Art „Tawny Inside“ aufzubauen. Die Technologie wäre dann fest in Autos, Robotern, Computerspielen oder Fitnessgeräten datenschutzkonform verbaut, um die Reaktionen der Nutzer*innen zu messen. Erste Integrationen sind für Preise ab 900 Euro im Monat im Angebot.

„Dabei sind natürlich umfassende Information und die explizite Einwilligung der betroffenen Personen unerlässlich“, sagt Bartl. „Die Technologie mag teilweise beunruhigend erscheinen. Sie wird sich aber als KI-Assistenzsystem etablieren, mit entscheidenden Vorteilen in den Bereichen Sicherheit, Komfort, Customer & Employee Experience – und dabei immer konform mit den bevorstehenden europäischen KI-Regulierungen als Qualitätsmerkmal im internationalen Vergleich.“

Fallbeispiel: Indeed-Spot mit Ingrid bleibt in Erinnerung

Tawny hat im Februar 2022 einen Spot des Jobportals Indeed analysiert. Darin stellt das Testimonial Ingrid das Jobportal vor und betont, dass Indeed Tausende von Websites nach dem richtigen Job durchsucht – „so wie ich Tausende von Websites durchsucht habe nach der passenden Bluse“. Ingrid trägt eine Bluse mit auffälligem Blumenmuster, was eine über den Laptop zugeschaltete Kollegin kommentiert: „Dafür muss man wirklich der Blumentyp sein.“ Ingrid erwidert: „Ich bin der Blumentyp.“ Und man sieht im Hintergrund, dass ihre Wohnung über und über mit Blumen dekoriert ist.

Resultat: Der 20-Sekünder hat eine insgesamt steigende Valenz-Kurve, wirkt also emotional positiv. Der erste Höhepunkt, die sogenannte „Time to First Peak“, kommt nach fünf Sekunden – Ingrid zeigt ihr Handy mit der Indeed-App. Dann flacht die Kurve ab, es kommt eine fast horizontale Linie. Das heißt, der Mittelteil verläuft ohne große emotionale Ausschläge. Gegen Ende – ab „Ich bin der Blumentyp“ – zeigt die Kurve dann deutlich aufwärts. Im Vergleich zu Benchmark-Spots liegt das Ende damit gleichauf mit den Top-Performern. Der Anfang setzt bereits einen emotionalen Trigger nach zwei Sekunden und leitet damit die positive emotionale Aktivierung ein. Insgesamt also ein Spot mit einem schnellen Hook und einem positiven Ende, das für 80 bis 90 Prozent des emotionalen Gedächtnisses verantwortlich ist. Mit anderen Worten: Der Spot bleibt in Erinnerung.