Das Problem mit dem Sarkasmus

Sascha Lobo hat in seiner jüngsten Kolumne auf Spiegeln Online geschrieben, dass es derzeit noch unklar sei, wie das Zusammenspiel zwischen Staaten und Unternehmen aussehen wird. Ein einzelnes „Lex Facebook“ sei wenig sinnvoll. „Viel eher müssten für eine kluge Regulierung vom Konzept Datenschutz über Mediengesetzgebung bis zu einer Reihe von Grundrechten (etwa zu Zensur und Meinungsfreiheit) umfangreiche Updates erarbeitet werden“, konstatiert der Digitalexperte.

„Die Kommentare zu löschen, ist die simple Lösung“, sagt Burchardt. Für ihn ist das nicht konstruktiv. „Gerade bei Kommentaren im besagten Graubereich, bei denen es keine juristische Handhabe gibt, hilft das Löschen nicht.“ Statt den Kommentar zu entfernen, könne man auch versuchen, einen Diskurs mit dem Verfasser aufzubauen und mit ihm ins Gespräch zu kommen, so der Wissenschaftler. „Spätestens bei diesem Schritt sind Menschen gefragt. Da kann die Maschine im Vorfeld lediglich filtern und sortieren.“

Die Ursache von Hasskommentaren sei auch durch künstliche Intelligenzen kaum lösbar, glaubt indes die Medienlinguistin. „Mit der Lösung des Symptoms kann man aber schon viel bewirken“, sagt Jaki.

Durch die Hasskommentare einer Minderheit wird der Eindruck erweckt, dass die Gesellschaft geteilt sei. Die Verringerung der Sichtbarkeit kann da sicherlich entgegenwirken.

Eine der spannendsten Fragen, betonen die Wissenschaftler, sei folgende: „Wie geht man mit Sarkasmus um?“ Denn es handele sich bei Aussagen aus dieser Kategorie selbstverständlich nicht um Hasskommentare, aber sie erfüllten häufig die Kriterien dafür.

„Kommentare zu löschen, ist die simple Lösung“

Forscher des MIT in Cambridge haben sich diesem Problem gewidmet, wobei sie zunächst ein System erschaffen wollten, das rassistische Beiträge auf Twitter erkennt. Dann fiel dem Team auf, dass sich viele Aussagen ohne die Beachtung von Sarkasmus nicht kategorisieren lassen. Der auf „Deep Learning“ basierende Algorithmus namens DeepMoji trainierte mit 1,2 Milliarden Tweets, die zudem eine Kombination aus 64 Emojis beinhaltete. Im Test schnitt er besser ab als Menschen. Während die menschlichen Prüfer in 76 Prozent der Fälle richtig lagen, erreichte DeepMoji einen Wert von 82 Prozent.

Der US-Konzern Alphabet und dessen Tochter Google arbeiten ebenfalls seit geraumer Zeit an einem Algorithmus, der bösartige und beleidigende Aussagen erkennen und Unterhaltungen im Netz verbessern soll. Deren Projekt trägt den Namen „Perspective“ und wurde von der Forscherinitiative „Conversation AI“ programmiert. Dabei handelt es sich um einen Algorithmus, der Hasskommentare selbständig erkennt und darüber hinaus fortwährend dazu lernt. Die sogenannte API (Programmierschnittstelle) erkennt mit Hilfe von Techniken des maschinellen Lernens verschiedene Arten von Beleidigungen. Auf der Homepage heißt es dazu: „Wir möchten herausfinden, wie Computer lernen können, die Nuancen und den Kontext solcher Äußerungen in größerem Maßstab zu verstehen. Maschinelles Lernen könnte dann Verlagen, Webpublishern und Moderatoren helfen, Kommentare auf ihren Plattformen besser zu verwalten, und so den Ideenaustausch im Internet fördern.“ Kooperationen bestehen mit der New York Times, The Guardian, The Economist und Wikipedia.

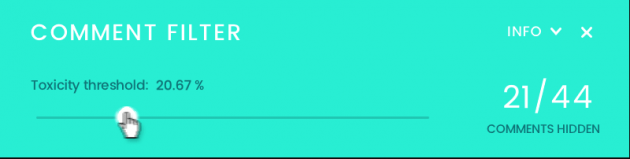

Die Schnittstelle dient dazu, den Algorithmus unterschiedlichen Forschern für die Entwicklung ihrer Tools gegen Hasskommentare zur Verfügung zu stellen. Das erste Projekt aus dieser Reihe bildete Anfang 2017 ein Schieberegler, der Kommentare zu verschiedenen Diskussionen auf einer Skala von 1 (sehr konstruktiv) bis 100 (Hate Speech) einordnet. Das Tool hat dabei verschiedene Aussagen zu den Themen Klimawandel, Brexit und der US-Wahl analysiert. Es versucht die Sätze ganzheitlich und somit nicht lediglich nach Stichwörtern auf ihren „toxischen Gehalt“ zu untersuchen. Ein Selbstversuch ist hier möglich.

Der Kommentar-Filter ist eine andere digitale Erweiterung, die auf dem Algorithmus „Perspective“ basiert. Dabei können Leser selbständig auswählen, wie viele vermeintliche Hasskommentare sie sehen möchten. Je nachdem wie stark der Filter eingestellt ist, werden die Kommentare für den Nutzer mehr oder weniger verborgen. Jene Tools sind bislang lediglich für den englischsprachigen Raum verfügbar.